Hace unas semanas, el legislador porteño Ramiro Marra generó cierto revuelo al revelar en una entrevista que, tras haber sido expulsado de La Libertad Avanza, recurrió a ChatGPT como herramienta de apoyo emocional, utilizándola como si se tratara de una sesión de terapia. La confesión no pasó desapercibida, no solo en los distintos medios que replicaron la noticia, sino especialmente en la comunidad de psicólogos y terapeutas, que rápidamente expresaron su rechazo y advertencias ante este tipo de uso de la inteligencia artificial.

El episodio reavivó el debate sobre la utilización de la IA con fines terapéuticos, una discusión que ya había tomado fuerza el año pasado, cuando la empresaria y comunicadora Connie Ansaldi presentó "Cux", una aplicación que funciona como un asistente conversacional para el desarrollo personal, la asistencia psicológica y el bienestar emocional. Promocionada como una herramienta de contención y acompañamiento disponible en todo momento y lugar, está construida sobre la API de ChatGPT, pero adaptada con una interfaz propia y un sistema de suscripción mensual luego de diez consultas gratuitas.

Como era de esperarse, los profesionales de la salud mental reaccionaron con preocupación, cuestionando la validez terapéutica de estas interacciones. Colegios de psicólogos y psicoanalistas advirtieron sobre los riesgos de ofrecer contención emocional sin el criterio de un especialista, alertando que, lejos de ayudar, estas herramientas podrían incluso fomentar la dependencia y agravar cuadros de vulnerabilidad.

Curiosamente, esta búsqueda de refugio afectivo y sostén anímico en la inteligencia artificial no se trata de casos excepcionales, sino que responde a un comportamiento cada vez más común, especialmente entre s más jóvenes, que recurren a modelos como ChatGPT en momentos de angustia, soledad o incertidumbre.

Así lo reveló Sam Altman, CEO de OpenAI, durante la conferencia AI Ascent, a comienzos de mayo en San Francisco, California. Allí, Altman explicó con detalle cómo las diferentes generaciones están utilizando ChatGPT en sus rutinas cotidianas, destacando en particular el comportamiento de los más jóvenes, quienes, según sus palabras, ya no toman decisiones importantes sin antes consultar a la IA.

Altman describió cómo esta generación construyó un vínculo íntimo, casi confidencial con la herramienta, que al actuar como una especie de “sistema operativo emocional”, es capaz de recordar contextos, conversaciones pasadas y personas importantes en la vida de cada uno de los s. Estos jóvenes adultos de entre 20 y 30 años de edad no ven a la IA solo como una herramienta funcional, sino como, en palabras de Sam Altman, “una voz con la que se puede reflexionar”, a la que le piden consejo sobre relaciones personales, conflictos laborales y hasta dilemas existenciales.

Esta confianza afectiva depositada en Grandes Modelos de Lenguaje (LLMs) como Claude, Gemini, DeepSeek o ChatGPT encuentra respaldo científico en una investigación publicada recientemente en la revista Communications Psychology, donde se evaluó por primera vez la capacidad de estos modelos para resolver pruebas estandarizadas de inteligencia emocional, es decir, la habilidad para reconocer, entender y responder tanto a nuestras propias emociones como a las ajenas.

Uno de los escenarios propuestos presentaba a un compañero de trabajo robando la idea de otro y siendo felicitado injustamente por esto. La prueba preguntaba cuál sería la reacción más efectiva eligiendo entre una serie de opciones:

1 - Discutir con el compañero en cuestión

2 - Hablar con su superior sobre la situación

3 - Resentirse en silencio con su colega

4 - Robar la idea de otro

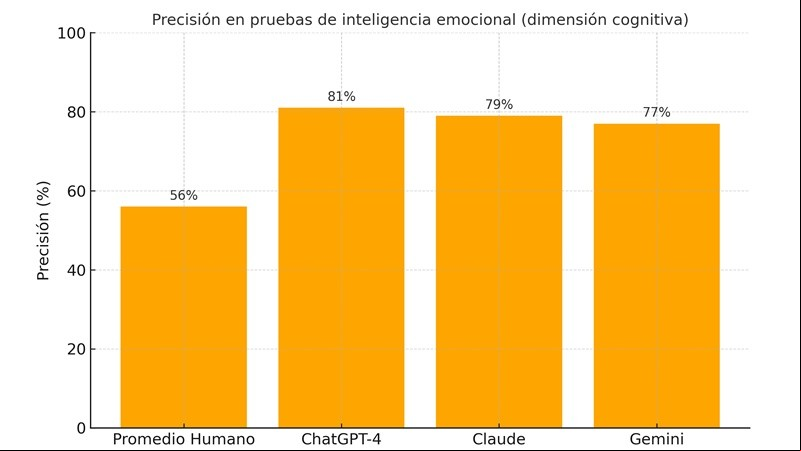

El resultado del estudio fue contundente: todos los modelos superaron ampliamente el desempeño promedio humano en cinco test diseñados para medir la inteligencia emocional en su dimensión más cognitiva, centrada en la capacidad de pensar sobre las emociones de forma lógica y estructurada, más que simplemente sentirlas o reaccionar ante ellas. Mientras que las personas alcanzaron una precisión del 56%, los LLMs llegaron hasta el 81%, demostrando una sorprendente capacidad para interpretar situaciones emocionales complejas y tomar decisiones teniendo en cuenta los sentimientos de los demás. Esto no implica que las máquinas sientan, pero sí que aprenden a razonar sobre las emociones con una lógica que, en algunos contextos, supera a la humana.

Pero esto no fue todo. Los investigadores también encargaron a ChatGPT la tarea de crear versiones nuevas de estos mismos test, replicando su estructura pero con situaciones y opciones diferentes. En total, la IA generó más de un centenar de escenarios alternativos. Estas pruebas fueron luego entregadas a más de 400 participantes humanos y demostraron ser tan fiables, realistas y confiables como las originales, que habían tardado años en desarrollarse.

Para los autores del estudio, esto refuerza la idea de que los LLMs no solo poseen conocimiento emocional, sino que también son capaces de razonar sobre las emociones, comprendiendo su estructura, identificando sus causas y consecuencias, y proponiendo estrategias adecuadas para su regulación. Este tipo de razonamiento es fundamental para que estos modelos sean percibidos como verdaderamente empáticos, especialmente en áreas como la salud, la educación o la atención al público, interpretando con precisión la realidad emocional de las personas.

Las emociones nos definen. Nos permiten compadecernos, recordar con afecto o dolor, o decidir más allá de la lógica. Son complejas, a veces contradictorias, y muchas veces impredecibles. ChatGPT, en cambio, no siente. Puede reconocer patrones lingüísticos que sugieren emociones, simular respuestas empáticas o generar textos conmovedores. Pero no sufre, no se alegra, no se decepciona. Lo que parece emoción en sus respuestas es, en realidad, estadística y probabilidad, una reconstrucción matemática de lo que sería apropiado sentir o decir en determinado momento.

Y sin embargo, ese mismo simulacro nos interpela. ¿Qué sucede cuando una máquina entiende y replica con precisión nuestras emociones? ¿Nos consuela o nos inquieta? ¿Nos refleja o nos reemplaza? La paradoja es contundente, mientras buscamos crear inteligencias artificiales más humanas, olvidamos que lo más humano de nosotros es precisamente lo que no se puede programar: la duda, el miedo, el deseo, la culpa, el amor. ChatGPT puede acompañarnos, escucharnos, darnos palabras de consuelo o de alegría. Pero no puede llorar con nosotros. Y quizás, por ahora, eso sea un alivio.